Eléments de cours

1 - Inflation et déflation

A ) Un processus complexe à mesurer

L’inflation est habituellement définie comme « un processus de hausse cumulative et auto-entretenue du niveau général des prix ». Il faut s’arrêter sur plusieurs éléments de cette définition. D’abord, l’inflation est une hausse du niveau général des prix : il ne suffit pas que quelques prix, ni même que les prix dans un secteur donné, augmentent pour qu’on puisse parler d’inflation. Il faut que, de manière générale, et en moyenne, les prix augmentent dans l’économie. Cette augmentation doit être d’assez long terme : on mesure généralement l’inflation sur un rythme annuel, ce qui permet d’évacuer, par exemple, les variations saisonnières des prix. Ensuite, il faut que cette hausse des prix soit cumulative et auto-entretenue : l’augmentation de quelques prix conduit à la hausse d’autres prix. Par exemple, quand les prix de l’énergie augmentent, les entreprises voient leurs coûts de production augmenter et pourront répercuter cette augmentation sur le prix de leurs produits, cette hausse aura des répercussions sur les prix des produits des entreprises qui intègrent ces produits comme consommations intermédiaires…

L’augmentation générale du niveau des prix a des conséquences importantes et sa mesure conduit à d’importantes controverses. Cela tient notamment aux répercussions politiques de la mesure de l’inflation. Le taux d’inflation entre, en effet, en jeu dans la prise de décisions politiques importantes. Cela a longtemps été le cas pour l’évolution du salaire minimum interprofessionnel de croissance (depuis 2013, le SMIC évolue en fonction du taux d’inflation – hors tabac – de la consommation des 20 % des ménages les moins riches). Par ailleurs, le taux d’inflation intervient dans la mesure de l’évolution du pouvoir d’achat des ménages, mesure qui donne lieu à d’âpres débats politiques.

Cependant, la mesure du taux d’inflation pose d’importantes difficultés. La première tient à la sélection d’un échantillon de produits pertinents. Il est en effet impossible de relever les prix de l’ensemble des produits qui s’échangent dans une économie. Il faut en choisir un échantillon représentatif. Cela nécessite de suivre les prix d’un nombre important de produits, ce qu’on appelle un « panier de biens et services ». Ce panier doit être le même et les prix relevés aux mêmes endroits d’une période à l’autre. La seconde difficulté tient au poids accordé, dans la mesure de l’inflation, aux prix des différents produits retenus. Il ne suffit pas de faire la moyenne de l’évolution des prix mesurés, il faut prendre en considération le poids de chacun des produits dans la consommation des ménages. Ainsi, l’évolution des prix de l’électricité a un impact bien plus important sur l’inflation que celle des bijoux de luxe. Les prix des produits sont donc pondérés par leur poids dans la consommation des ménages. La troisième difficulté, la plus importante, réside dans l’évolution des produits d’une mesure à l’autre : de nouveaux produits apparaissent, d’autres sont moins consommés. Surtout, la qualité des produits peut augmenter très vite à prix constant. Par exemple, le consommateur qui dépense aujourd’hui 500 euros pour acheter un ordinateur portable a un produit d’une qualité bien supérieure à celle d’un ordinateur au même prix un an plus tôt, et a fortiori dix ans plus tôt. Que doit faire alors le statisticien ? Peut-il considérer que le prix des ordinateurs reste stable ? Les prix sont souvent mesurés à « qualité constante », ce qui fait que, dans l’exemple donné, le prix des ordinateurs aura tendance à diminuer. Toutefois, les statisticiens tentent aussi de prendre en compte l’appréciation portée sur l’utilité du produit (approche dite des « prix hédoniques ») ce qui permet de prendre en compte le fait, dans notre exemple, qu’un ordinateur de 2003 n’aurait quasiment aucune valeur aujourd’hui et permet de relativiser la baisse des prix mesurée à qualité constante. De manière plus générale, des biais sont à éviter dans la mesure des prix, c’est ce qu’on appelle l’effet « Boskin », du nom du statisticien américain qui les a mis en évidence : l’effet qualité développé ci-dessus ; le fait que les prix relevés peuvent être ceux des mêmes produits d’une période à l’autre alors que les consommateurs peuvent se tourner rapidement vers des produits moins chers ; de la même façon, le fait que les consommateurs peuvent aller rapidement vers les points de vente où les produits sont les moins chers et l’apparition rapide de nouveaux produits.

En France, c’est l’INSEE qui est en charge de la mesure de l’inflation et qui doit affronter toutes ces difficultés. L’INSEE mesure l’indice des prix à la consommation chaque mois. Cette mesure se fait grâce au relevé mensuel des prix de 200 000 produits (160 000 dans les commerces et 40 000 sur Internet), pondéré par leur poids moyen dans la consommation des ménages. Le choix des produits et des points de vente se fait en toute indépendance pour éviter les manipulations de l’indice. Ainsi, il est fréquent de voir des personnes relever les prix de produits dans les grandes surfaces : ce sont des statisticiens de l’INSEE. Pour contrer l’effet Boskin, le panier des produits et les lieux de mesure des prix sont réévalués chaque mois, ils ne doivent cependant pas être bouleversés totalement pour pouvoir avoir des comparaisons valables d’un mois à l’autre.

Toutes ces précautions n’évitent pas les controverses sur la mesure de l’inflation par l’INSEE. Notons d’abord, que l’inflation ne prend en compte que les prix à la consommation et n’observe pas directement ce qui se passe pour les producteurs. La principale controverse tient à la différence entre l’inflation mesurée et celle ressentie par les ménages. L’inflation semble souvent sous-estimée par les ménages. Cela tient d’abord au fait que la mesure est une moyenne et l’inflation n’est pas la même selon la situation des ménages (lieu de vie, composition du ménage, âge des membres du ménages…). Par ailleurs, les ménages ont tendance à se focaliser sur le prix des produits consommés quotidiennement (la baguette de pain) ou sur les factures réglées fréquemment (facture d’électricité, prix de l’essence…) plus que sur ceux des produits achetés plus rarement (téléviseur, automobile…). Or, les prix des produits achetés plus fréquemment ont eu tendance à augmenter ces dernières années alors que les autres ont plutôt baissé. Ces questions ont conduit l’INSEE à développer des indicateurs plus subjectifs de mesure de l’inflation. Ces indicateurs subjectifs permettent de connaître le ressenti de l’inflation et peuvent être pris en compte pour connaître le ressenti de l’évolution du pouvoir d’achat par les ménages.

Enfin, les comparaisons internationales nécessitent une harmonisation des indices de prix, on calcule alors un indice des prix à la consommation harmonisé, sur des bases communes selon les pays. Cela fait que l’inflation mesurée dans les comparaisons internationales peut diverger légèrement de celle mesurée au niveau national.

B) Inflation, désinflation et déflation

Il y a toujours eu des variations de prix, dont les conséquences ont pu être très importantes. Ainsi, l’inflation est parfois présentée comme l’une des causes de la Révolution française.

E. Labrousse a distingué trois types de variation des prix : les variations saisonnières, de très court terme ; un mouvement cyclique de hausses puis de baisses qui correspond aux périodes de crise et de croissance (cycles dits « Juglar ») et un mouvement de long terme (la tendance générale sur plusieurs années, une fois ôtées les fluctuations de court terme). Sur l’ensemble du XIXème siècle, les prix sont plutôt stables dans l’ensemble des pays riches. Le mouvement est plutôt à la baisse des prix jusqu’au milieu du siècle puis les prix augmentent jusqu’en 1873. Dans le même temps, on assiste à d’importantes fluctuations de court terme, en fonction des récoltes agricoles ou encore des découvertes d’or (car la quantité d’or détermine la quantité de monnaie en circulation, dans le cadre de l’étalon-or).

La Grande Dépression, entre 1873 et 1896 conduit à une baisse des prix : c’est une période de déflation. On qualifie la période suivante, de 1896 à 1913, de « Belle époque », cette période de forte croissance s’accompagne d’une inflation assez importante. La première guerre mondiale conduit, ensuite, à une forte inflation dans la plupart des pays belligérants et dans leurs colonies. Le taux d’inflation fluctue beaucoup mais diminue, dans l’ensemble, en France, au Royaume-Uni et aux Etats-Unis. Ce n’est pas le cas en Allemagne. Entre le mois d’août et la fin de l’année 1921, les prix doublent, ils triplent sur les premiers mois de l’année 1922, avant d’être multipliés par six entre le mois d’août et la fin de l’année 1922. Il y a une forte accélération de l’inflation, et ce n’est qu’un début. Sur l’ensemble de l’année 1923, les prix sont multipliés par près d’un milliard ! C’est ce qu’on appelle l’hyperinflation. L’inflation correspond à une augmentation des prix et à une perte de pouvoir d’achat de la monnaie, l’hyperinflation est, elle, une augmentation très importante des prix et une perte totale de pouvoir d’achat de la monnaie. En Allemagne, en 1923, les prix des produits varient d’une heure à l’autre, toujours à la hausse. Il faut, au maximum de l’épisode d’hyperinflation, environ 600 milliards de marks pour acheter un kilo de pain. Les achats se font avec des brouettes de billets, que l’on ne compte plus : on les pèse. L’hyperinflation cesse grâce à un changement de monnaie en Allemagne. La crise de 1929 conduit à un épisode de déflation généralisée. Les prix baissent de 25 % aux Etats-Unis de 1929 à 1933. En France, les prix de gros diminuent de 46 % entre 1929 et 1935. La seconde guerre mondiale, comme la première, crée des tensions inflationnistes.

Après la seconde guerre mondiale, la plupart des pays riches connaissent une période de forte croissance, période que Jean Fourastié a qualifié de « Trente Glorieuses » pour la France. Cette forte croissance s’accompagne de niveaux d’inflation assez élevés. L’immédiat après-guerre est une période de tension sur les prix, notamment en France, en raison de la pénurie de nombreux biens et de la fin du fonctionnement des tickets de rationnement. Sur l’ensemble de la période allant des années 1950 à la fin des années 1960, le taux d’inflation dépasse en moyenne les 3 % chaque année en France et dans la plupart des pays développés. Le mouvement s’accélère à la fin des années 1960 et prend de l’ampleur dans les années 1970. C’est ce qui conduit l’OCDE à publier, en 1970, un rapport qui s’intitule L’inflation. Le problème actuel, rapport qui pointe le fait que les taux d’inflation dépassent les 5 %, ce qui semble correspondre à une situation de surchauffe de l’économie. L’inflation est particulièrement forte en France.

Le choc pétrolier de 1973 puis celui de 1979 accélèrent encore l’inflation. En 1974, le taux d’inflation en France est de 13,7 %, il est de 12,3 % aux Etats-Unis. La hausse du prix du pétrole vient accentuer les pressions inflationnistes qui existaient dans ces pays. Les prix augmentent même de 14 % en 1980 en France. L’ensemble des pays développés est touché. Seuls l’Allemagne et le Japon connaissent des taux d’inflation modérés.

En quelques années, cependant, l’inflation est maîtrisée dans l’ensemble des pays. Depuis les années 1980, les taux d’inflation sont, en moyenne, assez faibles. Pour la France, ils dépassent rarement les 3 % depuis le milieu des années 1980 et s’établissent à 2 % en moyenne. On a donc assisté à une forte désinflation : les prix ont ralenti, sans pour autant diminuer. Cela tient notamment à des politiques qui visent à lutter contre l’inflation (le G7 de Tokyo en 1979 officialise la priorité de la lutte contre l’inflation pour les politiques conjoncturelles des pays riches). D’autres facteurs sont également à l’origine de ce ralentissement de l’inflation : le prix de l’énergie a diminué jusqu’aux années 1990, les augmentations de salaire sont plus modérées (à la fois en raison du moindre pouvoir de négociation des syndicats, de l’augmentation du chômage et de la concurrence des pays à bas salaires) et la mondialisation qui diminue les coûts de production.

Cependant, depuis la crise de 2008, c’est plutôt la déflation qui est crainte : on a pu assister à une baisse des prix dans plusieurs pays et l’inflation a toujours été faible. La spirale déflationniste est une situation crainte. Le Japon a connu un épisode de ce type tout au long des années 1990 : la baisse des prix entraîne à la baisse les profits des entreprises et l’investissement. Cela joue à la baisse sur l’offre et conduit à une stagnation des salaires. La demande adressée aux entreprises diminue alors (baisse de la consommation et de l’investissement), ce qui déprime l’activité économique et, de nouveau, les prix. C’est un cercle vicieux dont il est difficile de sortir, notamment car les instruments traditionnels de la politique monétaire sont alors inefficaces.

C) Entre explications monétaires et réelles de l’inflation

L’inflation peut s’expliquer de différentes manières. L’explication la plus ancienne de l’inflation réside dans la quantité de monnaie en circulation. C’est une idée que l’on retrouve dans la « théorie quantitative de la monnaie » selon laquelle l’augmentation de la quantité de monnaie en circulation conduit à l’inflation. C’est également sur la théorie quantitative de la monnaie que s’appuie Milton Friedman pour exprimer le fait que « l’inflation est partout et toujours un phénomène monétaire ». Selon lui, le seul déterminant de l’inflation est la création monétaire. Il se base sur une analyse statistique pour étayer ses propos : il observe une corrélation, aux Etats-Unis entre la quantité de monnaie en circulation et le niveau des prix à la consommation entre 1964 et 1973. Ce sont les autorités monétaires qui sont la cause de l’inflation : une politique de création monétaire crée l’inflation.

Pour les auteurs keynésiens, les origines de l’inflation sont à rechercher ailleurs. Ils mettent en avant l’idée d’une inflation par la demande. Selon J.M. Keynes, l’inflation s’explique par le fait que la demande globale est supérieure à l’offre productive. L’appareil productif ne s’adapte pas assez vite à l’augmentation de la demande : l’inflation correspond à un phénomène de « surchauffe » de l’économie et ne se produit pas quand il y a des capacités de production non utilisées. La demande supplémentaire peut provenir de faibles taux d’intérêt qui conduisent à une création monétaire excessive, mais aussi d’un déficit budgétaire qui conduit à la distribution de revenus qui alimentent la demande ou encore d’une forte augmentation des salaires. En quelque sorte, l’inflation résulte d’une politique « keynésienne » en période de plein emploi.

Il existe une troisième explication conjoncturelle à l’inflation. Notons tout de suite que ces trois explications sont compatibles. Cette dernière explication est relativement simple : une augmentation des coûts de production conduit les entreprises à augmenter le prix de leurs produits. Les produits réalisés par ces entreprises peuvent être des consommations intermédiaires pour d’autres entreprises, qui augmentent à leur tour, les prix : il y a bien un processus auto-entretenu d’augmentation des prix. Ce processus ne se réalise pas, bien-sûr, dès qu’un prix augmente mais quand le prix d’un produit ou d’un facteur de production important dans l’économie augmente. C’est par exemple ce phénomène qui a eu lieu après les chocs pétroliers. Outre le prix des matières premières, une augmentation des salaires peut être à l’origine de l’inflation. On parle parfois de « boucle » prix-salaires : l’augmentation des salaires se répercute sur les coûts de production et les entreprises tentent d’atténuer l’effet de cette augmentation des coûts par une augmentation des prix. Cependant, face à l’inflation, les salariés vont revendiquer des augmentations de salaire. C’est l’une des explications de l’accélération de l’inflation en France au cours des années 1970. Ce phénomène est d’autant plus important que le pouvoir de négociation des salariés est élevé.

Il y a également des explications structurelles à l’inflation. Par exemple, l’étalon-or est un frein important à la création monétaire et explique la relative stabilité des prix au XIXème siècle. Le relâchement de la contrainte de l’étalon-or et la tendance à la concentration des entreprises, dans un cadre de moins en moins international a contribué à l’inflation au début du XXème siècle. De la même façon, le développement de l’Etat dit « Providence » a contribué à l’inflation car il a conduit à une montée des prélèvements obligatoires et à la distribution de revenus qui a alimenté la demande et donc l’inflation. Depuis les années 1980, la concurrence internationale accrue et la montée du chômage ont joué sur la modération de l’inflation, en renforçant l’importance de la compétitivité-prix pour les entreprises et en diminuant le pouvoir de négociation des salariés.

Pour comprendre les variations des taux d’inflation, il faut, bien-sûr, également tenir compte des politiques conjoncturelles et de leurs priorités : une priorité accordée à la lutte contre l’inflation aura tendance, logiquement, à conduire à des taux d’inflation plus modérés qu’une priorité accordée à la croissance ou à la lutte contre le chômage.

Enfin, la déflation a des causes spécifiques. Par exemple, une politique de désinflation trop vigoureuse peut conduire à la déflation si elle déprime trop la demande : le désendettement aggrave la déflation qui, à son tour, rend plus difficile le désendettement. Cela a été le cas lors de la crise de 1929 aux Etats-Unis. Il existe aussi un mécanisme de « déflation par la dette », mis en avant, notamment par I. Fisher : Ce mécanisme a joué sur la déflation du Japon au cours des années 1990.

2 - Le chômage : évolution et analyses

A ) Qu’est-ce qu’un chômeur ?

Le chômage est un phénomène relativement récent. Avant la fin du XIXème siècle, on ne parle pas réellement de chômeurs. Cela ne signifie pas que la force de travail était toujours entièrement utilisée avant cette période mais pour que l’on puisse réellement parler de chômeurs, il faut qu’il y ait des personnes sans activité professionnelle qui cherchent à en exercer une et sont disponibles pour l’exercer. Dans Le Capital, K. Marx évoque l’existence d’une « armée de réserve industrielle », composée de personnes sans emploi qui pourraient être employées. Le chômage apparaît donc avec la relation salariale telle qu’on la connaît. Tant que la majorité des travailleurs est indépendante statutairement, on ne peut pas parler de chômeurs : les indépendants ont plus ou moins d’activité mais ne peuvent pas être considérés comme étant au chômage. L’idée de chômage se précise quand elle est définie par un certain nombre de réformateurs sociaux, qui cherchent à prendre en charge les chômeurs. La notion de chômeurs apparaît pour la première fois en France lors du recensement de 1896. C’est durant l’entre-deux-guerres que l’Organisation Internationale du Travail officialise la définition du chômage telle qu’on la connaît aujourd’hui : un chômeur est une personne sans emploi, qui cherche à en exercer un et qui est disponible pour travailler. Cette définition est utilisée par les statisticiens de nombreux pays pour tenter de recenser les chômeurs. La mesure du chômage montre l’existence de nombreux chômeurs. C’est au Royaume-Uni, en 1920, que la première assurance chômage nationale est mise en place. Ces assurances se développent progressivement dans la plupart des pays. Elles naissent en France en 1958. L’Agence Nationale Pour l’Emploi a été créée en 1967 pour aider les chômeurs à trouver un emploi. Elle a fusionné avec les Assedic en 2008 pour former Pole Emploi, administration qui gère à la fois l’assurance chômage et aide les chômeurs à trouver un emploi.

Pôle Emploi est à l’origine de l’une des deux grandes mesures du chômage en France. Pôle Emploi distingue trois catégories de demandeurs d’emplois : les « catégories A », personnes inscrites à Pôle Emploi et n’ayant pas travaillé du mois ; les « catégories B », qui recherchent un emploi tout en ayant travaillé moins de 78 heures dans le mois et les « catégories C », demandeurs d’emploi ayant eu une activité réduite de plus de 78 heures dans le mois. La mesure donnée fréquemment dans les médias est celle des chômeurs « catégorie A », qui est la plus proche de la définition du Bureau International du Travail. C’est l’INSEE qui applique la définition du BIT à la lettre : la mesure de l’INSEE du nombre de chômeurs se fait notamment via les recensements et, surtout, l’Enquête emploi. Quelle que soit la mesure retenue (dont les résultats sont proches), elle comporte des limites et peut être sujette à des controverses. L’INSEE évoque l’existence d’un « halo du chômage » : certaines personnes ne sont pas classées comme chômeurs alors que leur situation est très proche du chômage. Il est à noter que les chômeurs font partie de la population active qui regroupe ainsi toutes les personnes qui occuperaient un emploi si l’on était en situation de plein emploi. Le taux de chômage est alors le rapport entre le nombre de chômeurs et la population active.

B) Du chômage frictionnel à un chômage de masse

Au début du XXème siècle, le chômage semble relativement faible. C. Thélot et O. Marchand dans Le travail en France [1997] estiment que le taux de chômage en France en 1900 avoisine les 2 %. Si ce chiffre est révélateur d’une bonne santé de l’économie, il est difficile de le comparer au taux de chômage actuel car la partie de la population active salariée est assez faible et les travailleurs indépendants sont rarement comptés comme chômeurs, surtout au début du XXème siècle. Le taux de chômage reste assez faible jusqu’à la crise de 1929. C’est sous la « Grande dépression » que le chômage de masse fait son apparition et devient un problème social de grande importance. Le taux de chômage atteint 24,7 % de la population active aux Etats-Unis en 1933. En France, le nombre de chômeurs recensés passe de 450 000 à 850 000 entre 1931 et 1936 et la population active diminue de 8 % sur la même période. La question du chômage devient une question sociale très importante. Le sociologue P. Lazarsfeld et son équipe mènent une enquête en 1933 sur Les chômeurs de Marienthal qui met en évidence les conséquences sociales du chômage et la relégation des individus touchés par ce fléau. Le chômage est également la préoccupation principale de J.M. Keynes, qui cherche les causes du chômage dans la Théorie Générale de l’emploi, de l’intérêt et de la monnaie en 1936. Suite à la seconde guerre mondiale, la période de forte croissance s’accompagne d’un faible taux de chômage. Selon des données publiées par Angus Maddison le taux de chômage annuel moyen sur la période 1950-1973 est de 2 % en France, de 2,5 % en Allemagne, de 2,8 % au Royaume-Uni, de 4,6 % aux Etats-Unis ou encore de 1,6 % au Japon. C’est une période de « plein emploi » où le chômage est de nature « frictionnel » : les chômeurs sont des travailleurs en recherche d’un premier emploi ou entre deux emplois. Tous les individus qui cherchent un emploi en trouvent un ou presque. C’est à partir de la fin des années 1960 et du début des années 1970 que le chômage remonte. Cette situation est aggravée par le choc pétrolier de 1973. En France, toujours selon Maddison, le taux de chômage moyen en France est de 5,7 % entre 1974 et 1983. Cette période est une période de montée du chômage pour la plupart des pays riches (seul le Japon fait exception, avec un chômage moyen qui s’établit à 2,1 % par an entre ces deux dates, alors que celui des Etats-Unis est de 7,4 % par exemple). L’aggravation est durable pour la France qui ne retrouve jamais le faible taux de chômage des « Trente Glorieuses », alors que jusqu’à 2007, le taux de chômage aux Etats-Unis ne dépasse que rarement les 5 %. On peut parler d’un chômage de masse pour la France. Le taux de chômage passe de 3,1 % en 1972 à 12,5 % en 1993, ce qui représente une augmentation de 2,5 millions de chômeurs. Au début des années 2000, les pays anglo-saxons, le Japon et les pays d’Europe du Nord connaissent des taux de chômage relativement faibles alors que les autres pays européens connaissent des taux de chômage plus élevés. La fin du XXème siècle est une période de baisse du chômage (le taux de chômage en France passe de 10,7 % en 1997 à 7,7 % en 2001 selon l’INSEE, le taux repart à la hausse avant de diminuer à nouveau entre 2005 et 2008, année où il atteint 7,4 %. La crise de 2008 conduit à une forte montée du chômage dans la plupart des pays riches. Le taux de chômage atteint 9,8 % en 2012 selon l’INSEE en France, il a avoisiné les 10 % aux Etats-Unis au début de l’année 2009. En Espagne, le taux de chômage, selon Eurostat, est de 26,9 % en mai 2013 : plus d’un quart des actifs est au chômage. Outre l’augmentation importante du nombre de chômeurs, on a assisté à d’importantes modifications de sa nature depuis les années 1970 en France. D’abord, les taux de chômage élevés montrent que le chômage n’est plus seulement frictionnel. L’augmentation du chômage suite aux crises de 1973 et de 2008 montre l’existence d’un chômage « conjoncturel » : le chômage s’explique par une dégradation de la conjoncture économique. Une partie du chômage est aussi « structurelle » : il y a des personnes qui sont au chômage sur le long terme. L’INSEE définit comme « chômeur de longue durée » une personne qui est au chômage depuis au moins un an. Fin 2012, 40,8 % des chômeurs étaient des chômeurs de longue durée. Cette part est de 57,9 % pour les plus de 50 ans. L’existence d’un important chômage de longue durée est le signe de l’existence de personnes durablement éloignées de l’emploi. Enfin, il faut noter que toutes les catégories de personnes ne sont pas touchées de la même façon par le chômage : le taux de chômage est très élevé chez les jeunes, plus élevé chez les femmes que chez les hommes et plus élevé pour les moins qualifiés que pour les plus qualifiés.

C) Comment expliquer le chômage ?

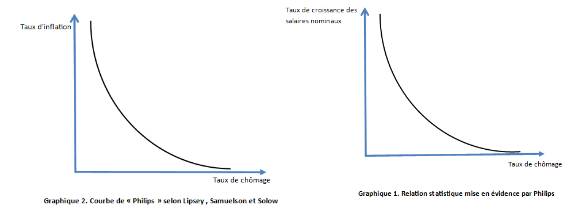

Pour un certain nombre d’auteurs néoclassiques tel que A. Pigou le chômage s’explique par des rigidités sur le marché du travail. Pour eux, le marché du travail peut être modélisé comme tout autre marché : l’offre de travail émane des travailleurs, sa demande provient des employeurs. Comme sur tous les marchés, à chaque prix (ici le prix du travail est le salaire réel) correspond une certaine quantité de travail offerte et une autre quantité de travail demandée. A un niveau élevé de salaire réel, l’offre de travail est élevée : de nombreux travailleurs offrent leur force de travail mais une demande plutôt faible : les employeurs sont rares à pouvoir demander de la force de travail à ce niveau (soit ils ne produisent pas, soit ils sont incités à substituer du capital au travail). Il existe un salaire d’équilibre qui assure le plein emploi. Cependant, il y a des rigidités qui empêchent le salaire d’atteindre ce niveau : il se fixe à un niveau plus élevé, qui fait que l’offre de travail est plus élevée que la demande, il y a alors du chômage. Ces rigidités peuvent provenir par exemple de l’existence d’un salaire minimum, de l’action des syndicats ou encore de l’assurance chômage (cette analyse est développée par J. Rueff dans « L’assurance chômage, cause du chômage permanent », article de 1931). Ainsi, l’assurance chômage fait que les salariés ne sont pas prêts à offrir leur travail pour un niveau de salaire inférieur au montant de cette assurance chômage. Cette approche est particulièrement pertinente dans un cadre néoclassique où le comportement des travailleurs est vu comme le résultat d’un arbitrage travail/loisirs. Dans le même ordre d’idées, la théorie du « Job Search » développée par G. Stigler dans les années 1960 indique que l’assurance chômage permet au travailleur de prendre le temps de collecter des informations pour obtenir un emploi le mieux rémunéré possible, plus ce temps peut être long et plus le salaire espéré sera élevé : le travailleur a donc intérêt à rester au chômage le plus longtemps possible pour espérer le salaire le plus élevé possible ensuite. Ce sont ces théories qui ont conduit les pouvoirs publics à mettre en place une indemnisation du chômage dégressive en fonction du temps. La question de la recherche de l’emploi est à la base de la théorie du chômage frictionnel, modélisée par la « courbe de Beveridge » qui met en évidence une relation décroissante entre taux de chômage et taux d’emplois vacants : plus le chômage est élevé et moins il y a d’emplois vacants, notamment car les chômeurs acceptent plus facilement les emplois qui leur sont proposés. En période de faible chômage, il y aura une tendance à l’existence de nombreux emplois vacants. Pour Keynes, ces analyses ne peuvent pas expliquer la forte augmentation du chômage suite à la crise de 1929 : les rigidités du marché du travail n’ont pas subitement augmenté et les travailleurs ne sont pas devenus soudainement plus exigeants… Il met en évidence l’existence d’un chômage « involontaire » : le chômage ne résulte pas toujours du comportement des travailleurs et il peut y avoir du chômage même quand de nombreuses personnes sont prêtes à travailler pour un salaire faible. Pour Keynes, il est illusoire de parler de « marché » du travail, notamment car les employeurs fixent leur « demande » de travail en fonction du salaire réel alors que les salariés sont victimes « d’illusion monétaire » et observent les salaires nominaux. Le chômage doit être analysé comme étant la résultante des décisions macroéconomiques. Les périodes de crise correspondent à des périodes où la demande effective est faible. Cela conduit les entreprises à investir peu et à ralentir leur activité. Dès lors, la « demande de travail » est faible. D’un autre côté, le comportement des travailleurs est déterminé par le salaire nominal, qui est rigide à la baisse. Il n’y a aucune raison pour que l’offre et la demande de travail coïncident et les périodes de crise conduisent à une forte chute de la demande de travail sans que l’offre de travail ne diminue (car les travailleurs ont besoin de leur salaire), ce qui explique le très fort chômage. C’est l’analyse (un peu simplifiée ici) qui est à la base des politiques de soutien à la demande préconisées par Keynes : le soutien à la demande joue sur la demande effective et incite les employeurs à augmenter leur demande de travail. D’autres explications d’ordre macroéconomique peuvent être parfois avancées : le progrès technique conduirait au chômage en rendant certains salariés inutiles. C’est une théorie qu’Alfred Sauvy a nuancé avec sa théorie du « déversement » : les emplois perdus dans certains secteurs (primaire d’abord puis secondaire) seraient gagnés dans d’autres secteurs. La mondialisation est parfois vue comme étant à l’origine du chômage : les salariés français seraient par exemple concurrencés par les salariés de pays à bas salaires. Là encore, la mondialisation détruit des emplois mais en crée d’autres (grâce aux nouveaux marchés conquis, à l’implantation de filiales étrangères) : la mondialisation, comme le progrès technique détruit certains emplois (industriels non qualifiés) mais en crée d’autres (qualifiés ou encore non qualifiés dans les services). En 1958, un économiste néo-zélandais, A. Philips met en évidence une relation statistique, pour la Grande-Bretagne entre 1861 et 1957, entre le niveau de chômage et le taux de croissance des salaires nominaux (Graphique 1). Plusieurs auteurs tentent ensuite d’apporter une explication à la relation mise en avant par Philips. C’est en 1958 que Lipsey apporte une formalisation mathématique et Samuelson et Solow proposent une réinterprétation qui relie la courbe de Philips à l’analyse keynésienne. Selon ces auteurs, on peut réinterpréter la courbe de Philips comme une relation décroissante entre taux d’inflation et taux de chômage. Elle devient alors porteuse d’un message d’une redoutable simplicité : il est possible, et notamment par la politique monétaire, de choisir entre inflation et chômage. Le chômage est alors le prix à payer d’une politique vigoureuse de lutte contre l’inflation. Pour les soubassements théoriques de cette analyse, il faut revenir au concept d’illusion monétaire développé par Keynes. Selon Keynes, en effet, les salariés raisonnent en termes de salaires nominaux. L’augmentation des salaires nominaux (et de manière générale de toutes les encaisses nominales, ce qui vient après une création monétaire importante) crée, certes de l’inflation, mais elle relance l’activité en stimulant la consommation et donc la demande effective. Par ailleurs, l’inflation permet une baisse ou au moins un maintien du niveau des salaires réels. Or, les employeurs raisonnent selon ces salaires réels : une inflation plus rapide que la croissance des salaires nominaux diminue les salaires réels et stimule l’embauche.

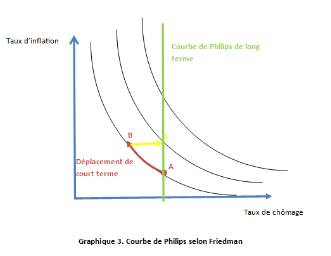

Cette analyse a été le cadre dominant des politiques économiques lors des Trente Glorieuses et le rôle des hommes politiques a alors été de trouver le juste milieu entre inflation et chômage. Cependant, le choc pétrolier de 1973 fait apparaître une situation de stagflation, coexistence d’une augmentation du chômage (stagnation de l’activité économique) et d’une accélération de l’inflation. L’explication de ce phénomène est donnée par M. Friedman. Dans un article de 1968 sur la politique monétaire, il constate qu’il est impossible de tracer des courbes de Philips pour tous les pays à toutes les périodes, il cherche alors à invalider l’analyse économique de la courbe de Philips. Pour ce faire, il s’attaque au principal fondement théorique de la courbe de Philips : l’illusion monétaire. Pour lui, cette illusion existe mais ne dure qu’un temps : au bout d’un certain temps, les salariés se rendent compte qu’en parallèle à l’augmentation de leurs salaires nominaux, les prix ont augmenté et qu’ils n’ont donc pas gagné en pouvoir d’achat. Ils réclament alors de nouvelles augmentations de salaires, ce qui augmente à nouveau le chômage puis crée de l’inflation. Les anticipations des salariés sont « adaptatives ». Pour Friedman, l’analyse de la courbe de Philips est vraie à court terme (déplacement en rouge sur le graphique 3) mais la correction de l’illusion monétaire conduit au déplacement du point B au point C : on retrouve le taux de chômage du départ avec un taux d’inflation plus élevé. A long terme, la courbe de Philips est une courbe verticale, qui montre qu’il existe un niveau de chômage indépassable sur le long terme, qui peut être qualifié de chômage structurel ou de chômage d’équilibre.

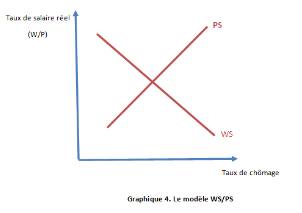

Cette notion de chômage d’équilibre est reprise par R. Layard, S. Nickell et R. Jackman, avec ce qu’on appelle le modèle WS-PS. Pour ces auteurs, il existe un chômage d’équilibre qui correspond à une sorte de compromis entre ce que souhaitent les syndicats et les employeurs. Ce modèle met en avant les négociations entre salariés et employeurs pour expliquer la relation entre le niveau de chômage et celui du salaire réel. Les salariés demandent un salaire d’autant plus faible que le niveau de chômage est élevé. Par ailleurs, les employeurs vont chercher une marge bénéficiaire d’autant plus faible que le niveau de chômage est élevé : les prix seront donc plutôt faibles et le salaire réel proposé par les employeurs sera alors plutôt élevé. Dans le graphique 4, la droite WS (wage-setting) traduit le comportement des salariés : plus le taux de chômage est élevé et plus le taux de salaire réel se fixe à un niveau faible. La droite PS (price-setting) traduit le comportement des employeurs : plus le taux de chômage est élevé et plus le taux de salaire se fixe à un niveau élevé (car les prix se fixent à un niveau faible). Il y a un taux de chômage d’équilibre et un taux de salaire d’équilibre. Dans ce modèle, le niveau du chômage va dépendre de la concurrence sur le marché et du pouvoir de négociation des salariés et des employeurs. Un moindre pouvoir de négociation des salariés déplace la droite WS sur la gauche et aura tendance à diminuer le taux de chômage d’équilibre.

L’importance accordée au pouvoir de négociation des salariés provient, à l’origine, du modèle microéconomique de base (ce pouvoir de négociation est une explication de la rigidité à la baisse des salaires) et se retrouve dans le modèle « insiders/outsiders » développé par A. Lindbeck et D. Snower. Pour eux, les insiders sont les salariés en place dans l’entreprise alors que les outsiders sont les candidats à l’emploi (les chômeurs). Les insiders ont un pouvoir de négociation dans l’entreprise car il y a des coûts de rotation de la main-d’œuvre pour les employeurs (coûts de formation, de la recherche et de la sélection d’un nouveau salarié, coûts de licenciement…). Les insiders demandent alors des salaires plus élevés que ceux qui résulteraient de la confrontation de l’offre et de la demande. Ces salaires élevés sont à l’origine du chômage. D’autres analyses mettent en avant les imperfections du marché du travail pour expliquer le chômage. C’est le cas, par exemple de la théorie du salaire d’efficience, développée notamment par G. Akerlof et J. Stiglitz. Pour eux, la productivité du travailleur va dépendre, en partie du salaire qui lui est proposé. Pour stimuler cette productivité, les employeurs proposent alors des salaires plus élevés que celui d’équilibre. Dans la même veine d’analyse, celle des « contrats implicites » (C. Aziaridis en 1975) indique que le chômage résulte d’une aversion du risque élevée chez les salariés. Ils cherchent à se protéger de fluctuations de leurs revenus et acceptent de toucher des salaires plus bas en période de bonne conjoncture en échange de salaires stables en période de mauvaise conjoncture. Il y a donc une rigidité des salaires qui explique le chômage dans un cadre néoclassique.

Enfin, la théorie de l’effet d’hystérèse peut expliquer le chômage de long terme. Le chômage passé explique le chômage actuel car les personnes qui perdent leur emploi perdent du capital humain et deviennent moins employables. En l’absence de politiques de formation, plus le chômage dure et plus il devient difficile de retrouver un emploi.

3 - Les crises financières et leur régulation

A) Les crises financières, un phénomène récurrent

Les crises financières désignent plusieurs crises de natures différentes : les crises boursières, les crises bancaires et les crises de change. Elles regroupent en fait toutes les crises, de plus ou moins grande importance, qui touchent l’un ou l’autre des domaines de la sphère « financière » de l’économie.

C. Kindleberger a décrit la succession de crises financières dans son Histoire mondiale de la spéculation financière. Si l’exemple de la panique boursière due à la spéculation sur les tulipes au XVIIème siècle montre bien les mécanismes à l’œuvre dans un phénomène de panique sur les marchés, il est plus pertinent de se pencher, avant tout, sur les crises financières depuis le XIXème siècle qui se déroulent dans le cadre d’une finance mondialisée et sur des marchés financiers plus développés. En 1873, par exemple, une crise financière de grande ampleur est venue mettre fin à une période de croissance. Cette crise est une crise bancaire et boursière due, notamment, à l’effondrement du marché immobilier en Europe et à la spéculation sur le chemin de fer aux Etats-Unis. En 1907, une crise bancaire de grande ampleur a eu lieu aux Etats-Unis, suite à un mouvement de « run » dans plusieurs banques (afflux de clients qui retirent leurs fonds placés dans la banque). C’est suite à cette crise qu’a été créée la Réserve fédérale des Etats-Unis (la « Fed »).

La crise financière de plus grande ampleur du XXème siècle a été celle de 1929. La période qui a précédé cette crise a été une période de forte croissance aux Etats-Unis, marquée par d’importants gains de productivité et une forte augmentation de la production industrielle. L’endettement privé a également augmenté, tout comme l’épargne placée en Bourse. La forte spéculation en période de croissance économique a conduit à une augmentation de la valeur des actions. Le Dow Jones est passé de 100 en 1924 à 381 en juillet 1929. Le krach boursier se produit à partir du jeudi 24 octobre 1929. Les spéculateurs ne croient pas la prédiction d’Irving Fisher qui, quelques jours plus tôt, avait dit que les prix avaient atteint un niveau plancher et qu’ils allaient se maintenir à ce niveau très élevé. Par crainte d’une future baisse des cours, ils cherchent à vendre leurs titres. En une demi-journée, le Dow-Jones perd près d’un quart de sa valeur. Les ventes sont très nombreuses. Après un calme relatif, le mardi 29 octobre (appelé parfois le « mardi noir »), les ventes repartent de plus belle et la chute du Dow Jones est encore plus importante. Le krach boursier prend encore de l’ampleur. Cette crise boursière d’une ampleur encore inégalée conduit rapidement à une crise bancaire, entre 1929 et 1933 près d’une banque sur deux fait faillite. Elle entraîne une crise sans précédent de l’économie « réelle », connue sous le nom de Grande dépression. Cette crise se propage à l’ensemble des pays développés (notamment en raison du repli protectionniste des Etats-Unis, de la propagation de la crise aux autres marchés financiers et du rapatriement des capitaux américains) et crée une crise du système monétaire international avec la fin du Gold Exchange Standard mis en place suite à la première guerre mondiale : la livre sterling devient inconvertible en or.

Après une période de relative stabilité après la seconde guerre mondiale, on assiste, depuis les années 1970 à une récurrence de plus en plus forte des crises financières. Parmi celles-ci, on peut mentionner la crise de 1987. C’est une panique boursière, née aux Etats-Unis en raison d’un déficit commercial plus élevé que prévu aux Etats-Unis, de l’instabilité du dollar, d’une remontée du taux d’intérêt allemand, mais aussi d’innovations sur les marchés financiers, qui amplifient les mouvements à la hausse ou à la baisse des marchés. Au début des années 1990, de nombreuses crises de change ont eu lieu en Europe, dans le cadre du Système Monétaire Européen. En 1994, c’est au tour du Mexique de connaître une crise de change en raison de l’appréciation du dollar, cette crise se propage à plusieurs pays d’Amérique du Sud (c’est ce qu’on appelle parfois l’effet « Tequila »). En 1997, c’est l’Asie qui est touchée par une crise financière de grande ampleur. Cette crise démarre par une crise immobilière suite à l’éclatement d’une bulle spéculative qui entraîne rapidement une crise bancaire de grande ampleur puis une crise de change (dévaluation très importante du bath thaïlandais par exemple). Quelques années plus tard, en 2000, ce sont à nouveau les Etats-Unis qui sont directement touchés par une crise boursière, que l’on qualifie parfois de crise de la « nouvelle économie » : une bulle spéculative s’était formée sur les valeurs de la « nouvelle technologie » (essor de nombreuses « start-up » innovantes) : l’indice Nasdaq avait été multiplié par 5 entre 1995 et 2000, cette bulle explose rapidement et le Nasdaq retrouve en 2002 le niveau qui était le sien en 1995. Après quelques années de calme relatif, une nouvelle crise financière intervient à partir de 2007 : celle des « subprimes ».

B) Des explications diverses

Toutes les crises suivent des schémas bien particuliers et ce qui est vrai pour l’une d’entre elles ne l’est pas forcément pour les autres. Cependant, les principaux schémas explicatifs des crises peuvent s’appliquer à la crise des subprimes. Certains auteurs mettront davantage l’accent sur l’un ou l’autre des facteurs mais il semble que l’on retrouve à l’origine de cette crise la plupart des facteurs explicatifs des crises financières. Les subprimes qui ont donné leur nom à la crise sont une innovation financière (un type nouveau de crédit). Ces innovations sont souvent à l’origine de crises : elles font espérer à la possibilité de profits élevés sans risques et conduisent à une forte augmentation de la demande de crédits ou bien de titres sur les marchés financiers. Lors de la crise des subprimes, d’autres innovations ont joué, comme le développement et le perfectionnement de la titrisation. Avant 1929, ce sont les « broker’s loans » qui ont favorisé la spéculation : ce sont des achats d’action financés en partie par l’emprunt, emprunt remboursé par les bénéfices engendrés par l’augmentation de la valeur de l’action. Nous avons également vu qu’une innovation a favorisé l’apparition d’une crise en 1987. L’innovation financière est à l’origine des bulles spéculatives. Ces dernières s’expliquent aussi par le comportement mimétique des spéculateurs. Ce comportement a été mis en avant par J M Keynes à travers la métaphore du concours de beauté : les spéculateurs n’ont pas à choisir les actions qui leur paraissent devoir rapporter le plus en fonction des fondamentaux de l’entreprise mais ils doivent choisir celles dont ils pensent que les autres spéculateurs les choisiront. Le comportement rationnel est d’agir comme les autres : mieux vaut se tromper avec tout le monde qu’avoir tort tout seul. C’est ce qu’André Orléan appelle la rationalité « autoréférentielle » et George Akerlof et Robert Shiller appellent les « esprits animaux ». En partant de ce raisonnement, il est facile de comprendre pourquoi des bulles spéculatives se forment : une anticipation de l’augmentation de la valeur des actifs financiers conduit l’ensemble des investisseurs à chercher à se procurer ces actifs, ce qui entretient la hausse. Une bulle de ce type s’est formée sur le marché immobilier aux Etats-Unis.

Les difficultés sur le marché immobilier américain sont venues de cette bulle immobilière et surtout des premières difficultés de remboursement qui ont mis en évidence les risques pris par les prêteurs et les emprunteurs. Hyman Minsky a proposé dans les années 1980 un modèle permettant de comprendre pourquoi ces risques ont été pris, modèle que l’on résume souvent par la formule de « paradoxe de la tranquillité ». Dans ce modèle, Minsky s’inspire de l’analyse de la crise de 1929 par I. Fisher. Selon Minsky, en période de stabilité économique, les agents économiques sollicitent des emprunts pour financer des projets d’investissement ou de consommation. Les banques accordent facilement ces crédits car les agents sont peu endettés et les gains escomptés des projets d’investissement permettent de penser que les crédits seront facilement remboursés. Le crédit stimule l’activité économique. Le succès des crédits accordés rend les prêteurs moins prudents et les investisseurs plus « gourmands » : les nouveaux crédits accordés sont de moins en moins sûrs, les risques sont sous-estimés. Les premiers crédits accordés correspondent à ce que Minsky appelle le « financement couvert » (hedge financing) : le paiement des intérêts et du capital emprunté est couvert par les profits attendus, on passe ensuite au financement « spéculatif » : les profits attendus (qui sont pourtant élevés) ne couvrent que les intérêts, le crédit pouvant être sans cesse reconduit. La crise a de fortes chances d’exploser quand prédomine le financement « Ponzi », du nom d’un escroc américain qui remboursait des prêts faits par des épargnants grâce à l’argent contracté auprès de nouveaux épargnants : les profits attendus ne couvrent même pas les intérêts et il faut sans cesse emprunter pour rembourser les anciens crédits. Pour Minsky, ce risque est intrinsèque au fonctionnement des marchés financiers.

D’autres explications peuvent encore être données à la crise de 2008 : plusieurs auteurs mettent en avant la politique monétaire « laxiste » de la Fed au cours des années 2000 (en partie en réaction à la crise des années 2000) : cette politique aurait conduit à une abondance de liquidités qui aurait aggravé le mécanisme mis en avant par Minsky. M. Friedman avait montré que la politique monétaire pouvait être à l’origine de la crise ou pouvait l’aggraver : il avait développé cette analyse à propos de la politique de la Fed après la crise de 1929 (la Fed avait mené une politique restrictive qui avait eu tendance à aggraver les choses et elle avait manqué de crédibilité dans sa politique). Le rôle de prêteur en dernier ressort joué par les Banques Centrales ou des institutions internationales (FMI par exemple) a plusieurs fois été accusé d’être à l’origine des crises. Les autorités monétaires ont joué ce rôle en 2008 pour lutter contre le risque systémique dû à la faillite d’une banque qui pourrait entraîner par contagion la chute de tout le système financier. Cette politique crée un aléa moral : les banques « too big to fail » pensent pouvoir prendre tous les risques puisqu’elles seront couvertes. C’est sans doute en partie pour diminuer cet aléa moral que les autorités américaines ont laissé Lehman Brothers faire faillite. Enfin, plusieurs auteurs mettent en avant la montée des inégalités pour expliquer la crise de 2008 : la croissance américaine du début des années 2000 n’aurait bénéficié qu’aux plus riches, ce qui aurait été un facteur important de développement du crédit. L’endettement privé s’est d’ailleurs développé dans de nombreux pays qui ont ensuite été lourdement touchés par la crise (cas de l’Espagne ou de l’Irlande par exemple). La crise financière s’est également aggravée dans les pays européens où la dette publique était importante (en Grèce et en Italie par exemple).

C) La régulation financière

Que faire pour limiter les effets des crises financières quand elles se produisent et comment faire pour empêcher que ces crises se produisent ? C’est à ces deux questions que cherche à répondre la régulation financière. Nous avons déjà présenté le rôle de prêteur en dernier ressort : il est censé éviter que la crise ne se propage. Les autorités monétaires ont aussi un rôle à jouer dans la régulation du crédit par l’action sur les taux d’intérêt qui doivent limiter les risques de gonflement des bulles spéculatives. Lors de la crise des subprimes, certaines banques en difficulté ont été nationalisées, ce qui a permis d’éviter leur faillite tout en ne laissant pas leur situation inchangée. C’est ce qui est arrivé à la Northern Rock au Royaume-Uni. La régulation financière doit aussi éviter la contagion des crises financières à l’économie réelle, par exemple en permettant le crédit en période de « credit crunch » suite à une crise bancaire. Cependant, cette régulation ne permet pas d’éviter la résurgence des crises financières.

Pour cela, différents instruments existent. Au début des années 2000, la Banque des Réglements Internationaux a développé la notion de régulation macro-prudentielle. Cette notion renvoie à la surveillance du risque systémique sur les marchés. Cette régulation doit correspondre à la mise en place de règles qui pourraient empêcher l’apparition de bulles spéculatives par exemple. Elle doit venir en complément de la régulation micro-prudentielle, qui, elle correspond à la régulation du comportement des agents pris individuellement. Les accords de Bâle, qui imposent des contraintes aux banques en termes de fonds propres (ratio Cooke décidés en 1988 qui impose aux banques de détenir des fonds propres égaux à 4 % des montants des prêts accordés puis ratio Mc Donough décidés en 2004 qui prennent en compte le risque des crédits accordés pour mesurer le niveau des fonds propres nécessaires) font partie de cette régulation micro-prudentielle. D’autres règles ont pu être mises en place pour encadrer l’activité des banques qui visaient à limiter le risque qu’elles prennent qui, on l’a vu est au cœur de l’analyse de la crise par Minsky : c’est le cas du Glass-Steagall Act qui, aux Etats-Unis, a imposé une séparation des activités de dépôt et des activités d’investissement entre 1933 et 1999. L’idée de régulation macro-prudentielle prend, elle, en compte le fait que la situation globale peut être risquée alors qu’aucun agent n’est particulièrement exposé au risque, notamment en raison de la titrisation. Le Conseil de stabilité financière mis en place par les pays du G20 est appelé à jouer un rôle dans la régulation de ce type.

Les agences de notation jouent un rôle important dans la régulation des marchés financiers puisque, via leurs notes, elles sont censées donner une information la plus fiable possible aux investisseurs sur le risque des différents placements possibles. Une voie de régulation passe donc par l’encadrement de l’activité des agences de notation, voire par la mise en place d’une agence de notation publique européenne par exemple.

Enfin, pour limiter l’ampleur des mouvements spéculatifs, il est parfois envisagé de contrôler l’innovation sur les marchés (limitation du « trading haute fréquence » qui consiste en des ventes et des achats automatiques de titres financiers en fonction de l’évolution de leur cotation sur les marchés). Une autre voie envisagée prend la forme d’une taxation des échanges. Cette idée, souvent nommée « taxe Tobin » est débattue au niveau européen : son application diminuerait l’incitation à la vente ou à l’achat trop fréquent des titres.